ollama 是什么

ollama 是一个完全免费的, 开源的, 多平台的大模型快速部署管理工具

不过这篇教程是 For Windows 的, 其他平台的用户可以自行必应了

支持的模型非常多 Llama 3.1, Phi 3, Mistral, Gemma 2 , qwen2(通义千问) 等等

并且傻瓜化操作, 上手非常简单, 理论上你只需要下载一个 Ollama 程序, 然后运行一个命令, 就可以部署一个模型了

当然为了保护我们可怜的 C 盘, 我们还是需要进行配置的

环境要求

下载

可以在官网下载: https://ollama.com/download

也可以在官方 Github 库的 Releases 下载: https://github.com/ollama/ollama/releases

推荐下载安装版的 OllamaSetup.exe

优点: 会自动安装系统服务,自动配置 path 变量

缺点: 所有东西都装在 C 盘, 你的剩余空间容易爆红。不过本教程就是为了解决这些问题的

安装和配置

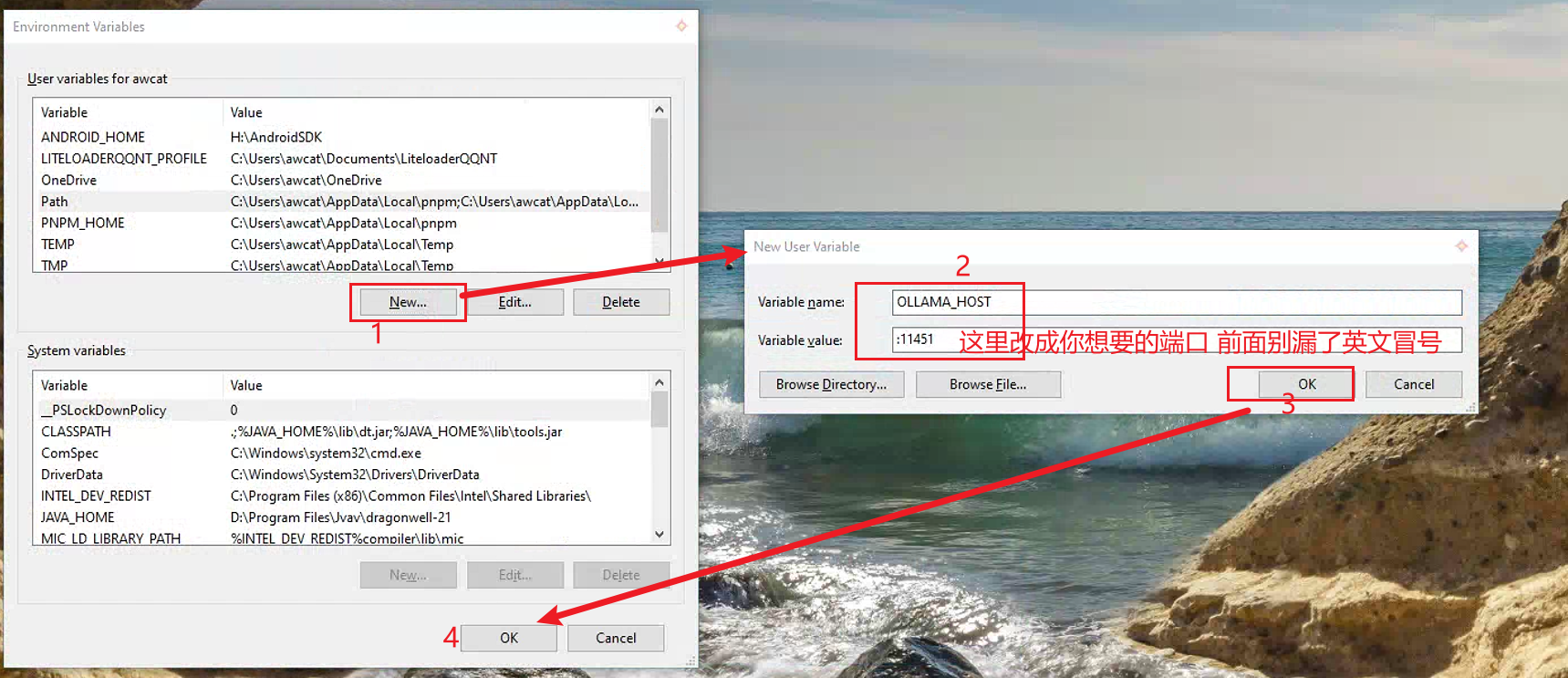

下载的过程中, 我们来顺手配置一下环境变量

修改监听地址

请注意: 如果您仅在本地使用, 没有外部访问需求, 建议您跳过这一步

按 win+r 快捷键, 输入 rundll32 sysdm.cpl,EditEnvironmentVariables 即可打开环境变量

我们需要添加名为 OLLAMA_HOST 的环境变量修改 Ollama 的 api 监听地址, 因为其默认情况下是 127.0.0.1:11451 , 这导致无法从外部或局域网进行访问

变量名 OLLAMA_HOST

变量值 :11451 (代表监听所有地址上的 11451 端口, 前面的英文冒号别漏了)

修改模型存储路径

如果你自信你的 C 盘够大, 或者你要部署的模型足够小, 可以跳过去, 我没意见)

同样地,添加环境变量:

变量名 OLLAMA_MODELS

变量值 E:\ollama 就是你想要存储模型的路径,你可以改成其他的

添加完别忘了确定。

接下来我们只需要运行安装程序,一路下一步就可以了。

使用

你可以在 官网 找找看你中意的模型

例如 llama3.1

复制之后打开一个 cmd 粘贴进去, 等下载完成后就可以开始对话了。

其他问题

懒得写了,写这篇文章写到一半该死的编辑器爆炸了还没自动保存

有问题在下面评论区问叭